Los SSDs, o unidades de estado sólido, llevan ya varios años entre nosotros en los que han ido sustituyendo poco a poco a los tradicionales discos duros, los HDDs, como la unidad de almacenamiento principal de los PCs. Aunque a día de hoy los HDDs siguen ofreciendo capacidades más altas a precios asequibles, los SSDs ofrecen innumerables ventajas para cualquier tipo de usuario, a saber: velocidades de transferencia muy altas, tiempos de acceso a disco bajísimos, bajo consumo energético, factores de forma mucho más pequeños y ligeros, e incluso han superado uno de los puntos débiles que sufrían las primeras generaciones de SSDs y se han puesto por delante de los HDDs en fiabilidad. No hay ninguna duda: los SSDs son un componente imprescindible en gran parte de los equipos modernos.

Sin embargo, ¿qué ocurre en los equipos destinados a jugar? A diferencia de otros componentes como el procesador o la tarjeta gráfica, los SSDs no influyen directamente en el rendimiento en tiempo real de los juegos. Salvo en casos muy concretos y muy poco deseables, los frames por segundo —fps— no se ven influidos directamente por la presencia de un HDD o un SSD. Una vez cargados todos los datos desde nuestra unidad de almacenamiento, el PC rara vez accede de nuevo si no es para almacenar o cargar un nuevo conjunto de datos: algo muy típico en muchos juegos de consola como es acceder al HDD para cargar datos en tiempo real, es algo poco habitual en los juegos de PCs, que normalmente se limitan a ello en los cambios de nivel.

Y aquí es donde radica el interés de los SSDs como elementos para jugar: en la experiencia de juego, que no sólo se limita a la calidad gráfica y a la fluidez en general del juego, sino también en nuestra paciencia como jugadores. En los tiempos de carga. Con los SSDs, atrás quedaron los días de esperar literalmente durante horas a que un juego se instalase. Hoy queremos indagar un poco más en este asunto; no sólo queremos mostraros que los SSDs marcan la diferencia a la hora de poner a prueba nuestra paciencia, sino también descubrir cómo, cuánto y por qué.

Si sois asiduos al mundo del hardware habréis leído más de un análisis de SSDs. Para ello, se usan programas como el CrystalDiskMark, IOMeter, ATTO, AS SSD, etc. Tampoco es descabellado ver pruebas menos sintéticas y calcular tiempos de lanzamiento de programas, de descomprensión de archivos, y otro tipo de pruebas más útiles en el día a día para la mayor parte de usuarios. Incluso se ve ocasionalmente algún juego, pero menos de lo que nos gustaría. Por eso, nosotros queremos ir más allá: hemos realizado una colección de pruebas exclusivamente sobre juegos. Nada de aburridos benchmarks, juegos de verdad, situaciones habituales a las que cualquier pecero se enfrenta en su día a día. Os vamos a mostrar la diferencia entre SSDs y HDDs, y también las diferencias entre SSDs de distintas generaciones.

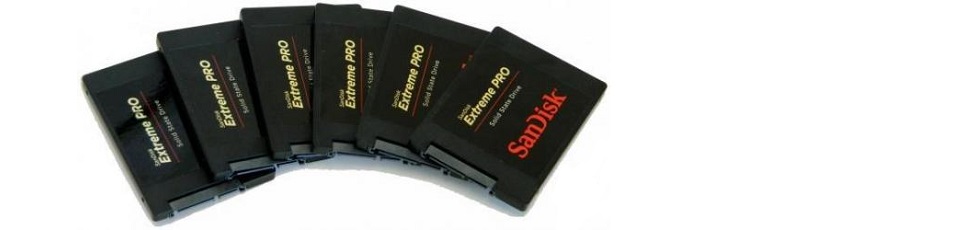

Para ello, SanDisk nos ha cedido su SSD tope de gama, el SanDisk Extreme PRO de 240 GB. Este modelo cuenta también con discos de 480 y 960 GB, y todos están orientados a competir con el resto de topes de gama de otras marcas. Como veremos, el SanDisk Extreme PRO se desenvuelve particularmente bien y supera a nuestro otro SSD de pruebas, el Intel SSD 330 de 180 GB, en todos los casos. SanDisk ha hecho tradicionalmente SSDs con un rendimiento más que notable, y el Extreme PRO no es una excepción. Desde un punto de vista más técnico, es un excelente SSD todoterreno de alta gama que no tiene ningún punto débil.

Para ello, SanDisk nos ha cedido su SSD tope de gama, el SanDisk Extreme PRO de 240 GB. Este modelo cuenta también con discos de 480 y 960 GB, y todos están orientados a competir con el resto de topes de gama de otras marcas. Como veremos, el SanDisk Extreme PRO se desenvuelve particularmente bien y supera a nuestro otro SSD de pruebas, el Intel SSD 330 de 180 GB, en todos los casos. SanDisk ha hecho tradicionalmente SSDs con un rendimiento más que notable, y el Extreme PRO no es una excepción. Desde un punto de vista más técnico, es un excelente SSD todoterreno de alta gama que no tiene ningún punto débil.

Al igual que la mayoría de SSDs actuales, viene en formato de 2,5”. Esto quiere decir que es válido tanto para equipos de escritorio como portátiles; en ese último caso, SanDisk incluye un pequeño soporte para usarlo en el caso de que nuestra ranura de 2,5” esté destinada únicamente a unidades estándar de 9,5 mm, porque el Extreme PRO mide únicamente 7 mm.

La característica más interesante es que incluye 10 años de garantía, situación que lo diferencia bastante de los competidores en su rango de precios, que a pesar de ser la gama más alta —dentro de la conectividad SATA 3— no suelen ofrecer un período tan largo ante posibles fallos. Ello se traduce en una vida estimada de 22 GB escritos por día. No os vamos a aburrir con muchos números, pero tened clara una cosa: es una auténtica barbaridad. Un usuario que le dé un uso medianamente intensivo es difícil que pase de 10 GB escritos al día de media, siendo más normales valores en torno a 5 GB.

Sin más dilación, os dejamos con el equipo de pruebas y la metodología usada, y los resultados del análisis en juegos:

Equipo de pruebas y metodología

CPU: Intel Pentium G3220 – 3,0 GHz

Placa base: MSI H81M-P33

RAM: Kingston HyperX Fury – 8 GB 1600 MHz

Gráfica: Radeon R9 270X – 2 GB

Caja: Corsair Carbide 200R

Fuente: Corsair CX 750M – 750 W

HDD: Western Digital Caviar Black – 1 TB

SSD 1: Intel SSD 330 – 180 GB

SSD2: SanDisk Extreme PRO – 240 GB

Hemos escogido 5 tipos de pruebas básicas, que son las más típicas a la hora de trabajar con juegos: copia de backup de una unidad a otra, instalación desde la propia unidad, inicio o lanzamiento del juego, inicio de una nueva partida, y carga de una partida guardada. Por la naturaleza de algunos juegos, las dos últimas pruebas pueden variar; las particularidades de cada caso están descritas en el propio juego.

La copia de backups, como su nombre indica, se trata de trasladar de una unidad a otra la copia de seguridad o archivos de instalación de cada juego. En el caso de la mayoría de juegos se trata del backup de Steam, aunque también se incluyen títulos de Origin, UPlay, y GOG. Es una operación pura de escritura en la unidad de destino, y para evitar cuellos de botella en la lectura siempre se copia desde un SSD a la unidad de destino.

La instalación del juego se realiza a través del propio backup o de los archivos de instalación, situados en la misma unidad en la que se realiza la instalación. Es una prueba muy intensiva de lectura y escritura simultánea, y representa muy bien la agilidad para trabajar con datos de entrada y salida de una unidad —comúnmente llamados I/Os—.

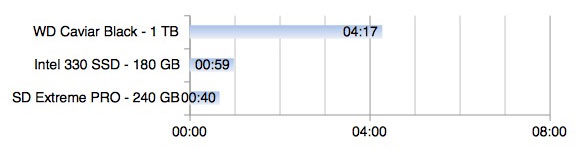

El inicio del juego es una medida del tiempo que se tarda en llegar al menú principal desde que lanzamos el juego; en la medida de lo posible hemos eliminado las pantallas de publicidad típica que aparecen al iniciar los títulos. Son operaciones de lectura puras que ocasionalmente hacen un uso ligero del procesador.

Por último, las pruebas siguientes miden el tiempo necesario para empezar a jugar desde el menú principal, ya sea iniciando una nueva partida o cargando un partida guardada anterior, siempre que sea posible.

The Witcher 2: Assassins of Kings

Con la más que esperada tercera parte recién lanzada, no podíamos resistirnos a probar la secuela original de nuestro brujo favorito, en un análisis 100% libre de downgrades.

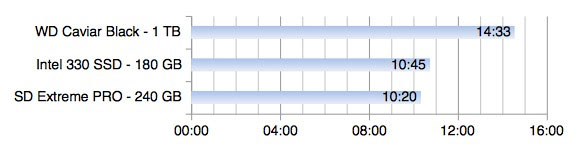

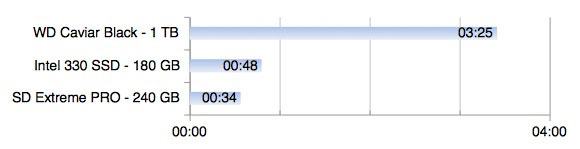

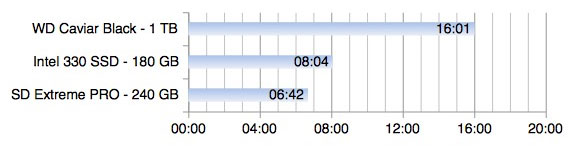

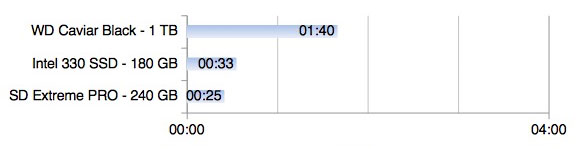

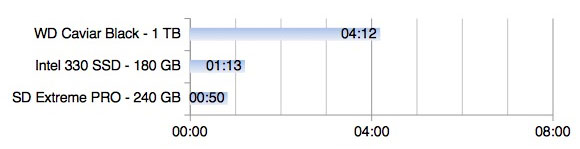

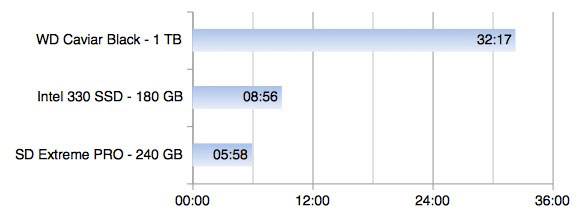

Como podemos observar, el tiempo de copia de backup [15,9 GB] es sustancialmente mejor en los SSDs que en el HDD de pruebas. El Extreme Pro consigue sacarle además una ventaja importante al 330, que quizá sea lo más sorprendente de la prueba. Una tendencia que seguirá en los próximos títulos aunque no tan acentuada para el Sandisk.

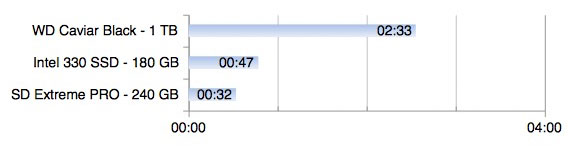

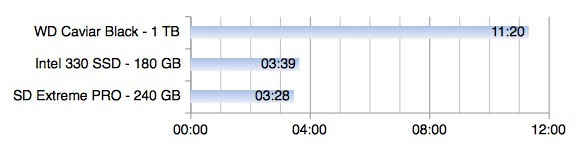

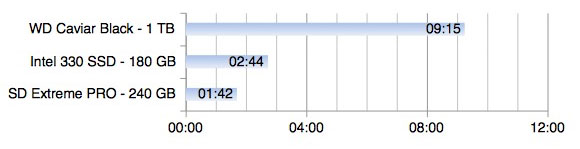

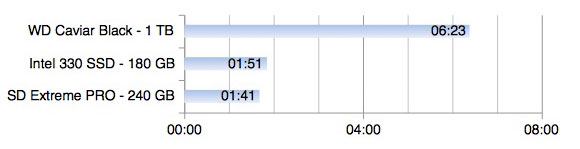

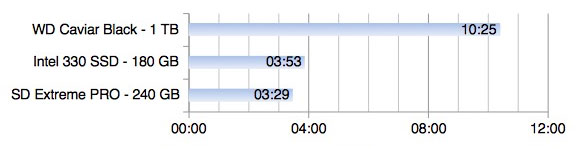

Las diferencias en el tiempo de instalación [18,9 GB] se acortan mucho más entre SSDs, que a su vez dejan a años luz al Caviar Black. Esto podría explicarse por lo bien comprimido que está el backup de Steam, y por la cantidad de pequeños archivos con los que tienen que trabajar las unidades de forma simultánea, un parámetro donde los SSDs brillan especialmente ante sus hermanos mecánicos, los HDDs.

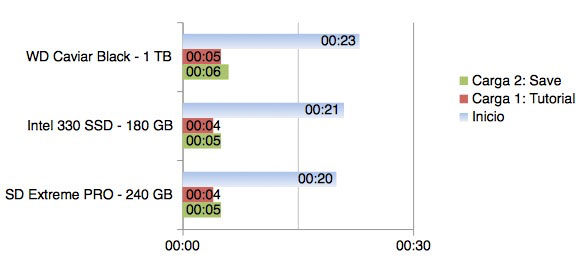

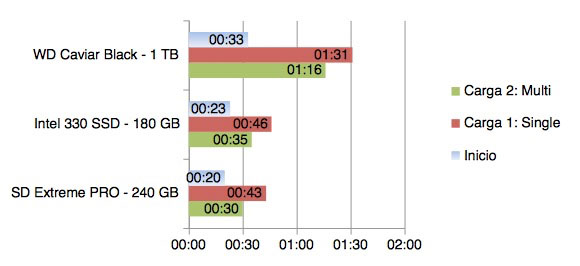

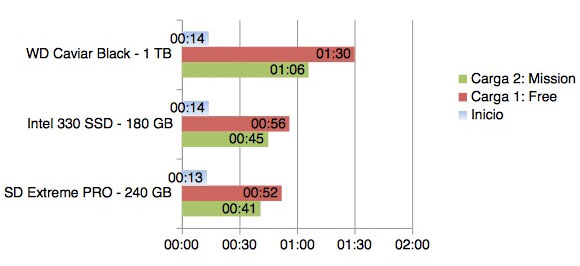

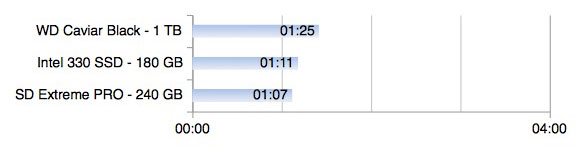

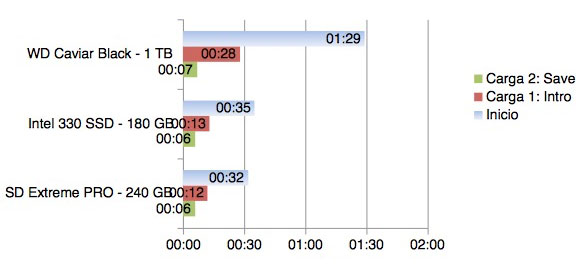

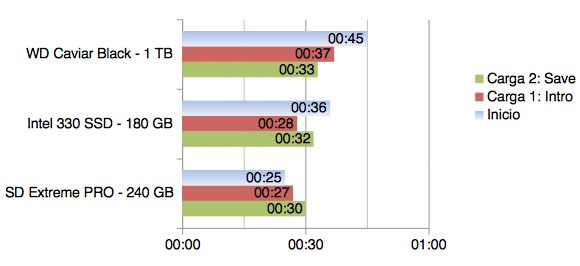

Sin embargo, las diferencias en el juego se diluyen. The Witcher 2 es un juego que confía mucho en la potencia de proceso del PC, y sobre todo en la capacidad de la tarjeta gráfica, y la gran mayoría de elementos que en otros casos se precargan durante la partida en este caso se calculan en tiempo real dentro del propio juego. Incluso para llegar al menú de inicio, las diferencias son mínimas: es un juego que se beneficia poco de tener un SSD, en la mayoría de ocasiones. Hemos usado el inicio de partida del tutorial, y una partida cargada en el inicio del propio juego, para este benchmark.

Pillars of Eternity

Si hay un género gordopecero por excelencia, es el del rol occidental. Pillars of Eternity es el heredero directo de clásicos como Baldur’s Gate, y después de sufrir interminables instalaciones hace 15 años con los 5 CDs de su precuela espiritual, teníamos que poner a prueba nuestros nervios una vez más.

La tendencia se mantiene con respecto al caso anterior: los SSDs son mucho más veloces en la copia del backup [6,33 GB], dejando a nuestro Caviar Black a la deriva.

En la instalación [15,6 GB], sin embargo, el HDD está mucho más cerca que en el caso anterior. Quizá la explicación radique en que el compresor de GOG está mucho menos optimizado y simplemente trabaje con una copia de archivos más grandes de lo habitual en instalaciones. Curiosamente esta situación sólo se repetirá con el instalador de Origin, que tiene algo de particular.

El tiempo hasta llegar al menú principal no es particularmente significativo y aunque hay una diferencia medible a favor de los SSDs, no es significativa. Sin embargo, empezar una partida nueva fue una tarea especialmente exhaustiva para nuestro HDD, mientras que ambos SSDs parecieron no inmutarse demasiado al respecto. El tiempo de carga de un savegame fue idéntico en los tres casos.

Team Fortress 2

Como no podía ser de otra manera, el juego más loco de Valve no podía fallar como principal representante del multijugador. Lo escogemos porque es un juego que ha sufrido centenas de parches en los años que lleva a las espaldas, y queríamos ver cómo influían todos los elementos en la carga del juego y de los escenarios.

No hay muchas sorpresas en la copia del backup [6,97 GB], la tendencia previa se mantiene.

En el caso de la instalación [14,7 GB], una vez más queda demostrado que el instalador de Steam es especialmente generoso con los discos de acceso rápido y los SSDs empatan virtualmente a una distancia visible del HDD.

Aquí ya vemos una clara diferencia a la hora de cargar niveles. Tanto en la prueba de single player, creando nosotros el servidor local, como en la de multiplayer, en la que escogimos a conciencia uno de nuestros servers favoritos —vacío, para evitar cuellos de botella por la conexión—, podemos ver una diferencia del orden del doble en los tiempos de carga. Los SSDs hacen que la espera sea mucho menos ardua, en ambos casos. Para la carga en Single Player escogimos Gold Rush, un escenario mediano de los más habituales en la modalidad Payload, y en el multijugador nos quedamos con 2Fort, otro de los niveles emblemáticos en el modo capturar la bandera.

Microsoft Flight Simulator X

El juego más antiguo de nuestro análisis, con diferencia. ¿Por qué escoger un juego así? Porque a día de hoy sigue poniendo a prueba a los equipos más potentes, y su configuración de mundo abierto obliga a las unidades a cargar un montón de elementos de forma simultánea para empezar a jugar. ¿O más bien sería simular?

Nada nuevo en la prueba de backup [8,43 GB]: seguimos viendo como los SSDs barren una y otra vez al HDD gracias a su mayor tasa de escritura.

Aunque no en este caso no es tan exagerado como en los anteriores, el instalador [16,4 GB] de Steam sigue proporcionando a los SSDs una cómoda ventaja sobre el Caviar Black.

Aunque en el inicio del menú principal no se saca ninguna ventaja, en la carga de niveles podemos ver como el HDD tarda de media un 50% extra de tiempo en permitirnos surcar los cielos. Tanto en el modo vuelo libre como en el modo misión, los resultados son consistentes entre las distintas unidades. Para la misión, escogimos la prueba 747 Test.

Battlefield 3

Battlefield 3 supuso un enorme salto cualitativo con respecto a sus predecesores, y quizá fue el juego que marcó una auténtica diferencia en el aspecto visual entre las consolas de la época y los PCs más potentes. Es también nuestro representante de Origin, que como veréis, tiene sus particularidades en nuestro análisis.

Los backups de Origin no son más que copias de la carpeta del juego. Incluso la propia EA lo suscribe como método más o menos oficial. No es de extrañar pues que los resultados sean similares a los casos anteriores en la copia del backup [20,6 GB]. En este caso, además, el Extreme PRO sale ganador con una ventaja considerable sobre el Intel 330 SSD.

Sin embargo, la instalación [20,6 GB] tiene su truco: hay que iniciar la descarga del juego en una carpeta donde no esté el backup, parar la descarga, y sobreescribir la carpeta con el backup anterior. Al reanudar la descarga, Origin realiza una verificación de archivos, crea algunas entradas de registro, y voilà, el juego ya está instalado. Por eso, las diferencias en este caso son mínimas. Es el único caso donde nuestro veterano Caviar Black da el tiempo, aunque no sea una instalación todas las de la ley.

Los tiempos de para llegar al menú e iniciar nueva partida son de nuevo bastante menores en nuestros SSDs, mientras que en la carga de un savegame no les da tiempo a brillar por lo corta que resulta y el HDD, de nuevo, mantiene el tipo. En general, parece ser una constante: cargar partidas una vez iniciado el juego es una actividad poco intensiva en la que los HDDs no sufren más que los SSDs. La misión escogida fue la inicial, Semper Fidelis, y el savegame fue otra misión más adelantada que teníamos pendiente.

The Elder Scrolls V: Skyrim

La última entrega de la saga TES la escogemos principalmente por los problemas que tuvo en sus primeras versiones de consola, en las que como Eurogamer demostró en su día un SSD podía mejorar la carga de texturas, principalmente. Aunque fue algo que se solucionó con parches y no es una situación en absoluto habitual en PCs, queríamos comprobar como mejora el resto de situaciones típicamente limitadas por el almacenamiento dentro del juego. Tampoco podemos obviar toda la polémica reciente sobre el cobro de mods en Steam, aunque nosotros utilizamos la versión original del juego, con lo que las mejoras se harán más patentes en instalaciones cargadas de más archivos.

En la copia de backup [4,84 GB] se confirma lo que ya venimos anunciando: los SSDs son muy superiores en escritura, y el SanDisk Extreme PRO mantiene su leve pero consistente ventaja sobre el Intel 330.

Nada nuevo tampoco en el tiempo de instalación [5,48 GB] a partir de Skyrim. Se confirma también que cuanto más complejo es el juego, más beneficios sacan los SSDs a partir del instalador del mismo.

Para los tiempos de carga esta vez no utilizamos el iniciar una nueva partida porque Skyrim parece no tener tiempos de carga en este aspecto, quizá por estar incluidos dentro del propio tiempo de carga hasta llegar al menú de inicio del juego. Así pues, la prueba la realizamos con dos savegames, uno cargando la partida en frío, nada más iniciar el juego, y el siguiente a partir de una partida en caliente, cuando ya llevábamos un rato jugando. La diferencia a favor de los SSDs, de nuevo, parece ser bastante constante: los tiempos de carga se reducen en torno a la mitad en las dos medidas que realizamos.

Might & Magic: Heroes VI

La saga Heroes of Might & Magic siempre ha ocupado un lugar en los corazones de muchos peceros. Aunque los últimos títulos pierdan parte de la magia con la que disfrutamos en los 90, siguen siendo juegos de estrategia muy sólidos y jugables. Aprovechando que recientemente se podía conseguir a través de Humble Bundle prácticamente toda la saga y spin-offs a un precio de risa, Heroes VI se convierte en nuestro representante de Uplay y ver cómo se comporta con respecto al resto de backups e instalaciones de Steam, Origin y GOG.

Los backups de Uplay no son más que los propios instaladores del juego, en un formato más propio de DVDs que de descargas digitales. En este backup [9,79 GB] los números no cambian: los SSDs barren al HDD de nuevo, con una ventaja apreciable del representante de SanDisk.

La instalación de Uplay se asemeja bastante más en números al de Steam que al de GOG, a pesar de tener formatos más similares. Lo curioso es que apenas hay una diferencia de 300 MB entre el instalador y la propia instalación del juego [10,1 GB], lo que nos hace preguntarnos el porqué de ese incremento tan grande de tiempos en la instalación, cuando no parece haber demasiado para descomprimir.

En los tiempos de carga sucede algo curioso: para llegar a la pantalla principal, el Intel 330 se acerca más al Caviar Black que al Extreme PRO. Esto habla bastante bien de la velocidad de lectura en el modelo de SanDisk, que aún por la mínima sigue siendo ligeramente más rápido en el resto de pruebas. Es particularmente curioso como cargar una partida guardada tarda más o menos lo mismo en todas las unidades, pero iniciar un juego nuevo en ese mismo nivel es más rápido en los SSDs. Claramente, Black Hole podría haber mejorado la optimización en este aspecto, que deja algo que desear.

Conclusiones

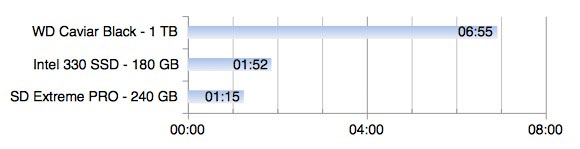

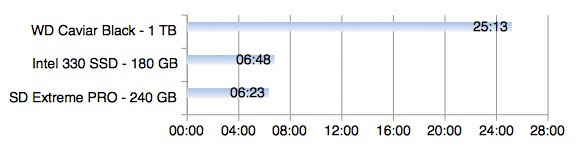

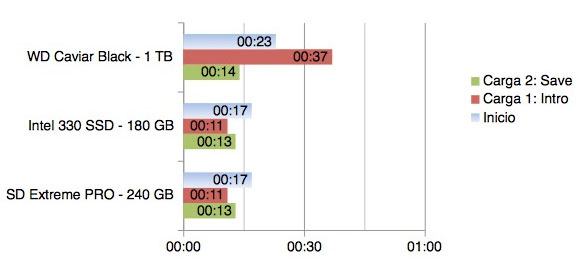

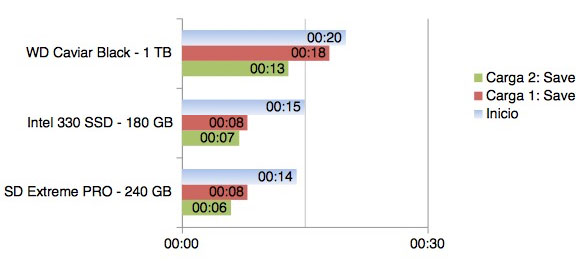

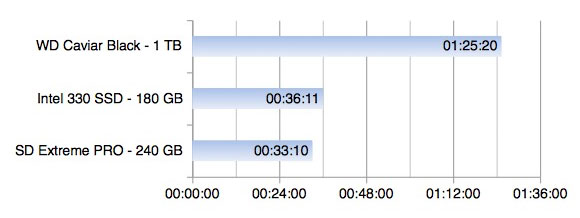

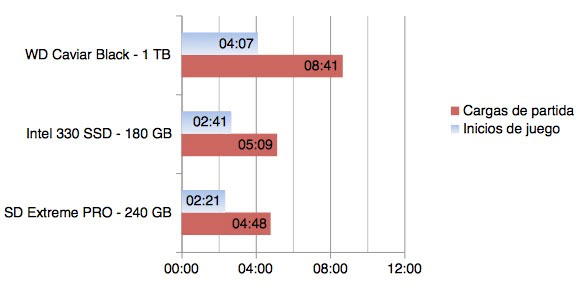

La realidad es aplastante: los SSDs mejoran los tiempos de carga enormemente. Recopilando los datos, esto es lo que tenemos después de analizar nuestros 7 juegos:

La mejora con respecto a nuestro HDD a la hora de mover backups de nuestros juegos es del orden de un 250% en el caso del Intel 330 SSD, y aún más bestia en el caso del SanDisk Extreme PRO: por encima del 400%. En una operación típica si gustamos de conservar los instaladores, ya sea por la comodidad de no tener que descargar juegos cuando queramos jugarlos, por tener una copia en caso de que la instalación original se dañe, o simplemente queramos conservar juegos sin DRM como los de GOG por lo que pueda pasar el día de mañana.

Las discrepancias entre la forma de descomprimir los archivos de los instaladores y crear la instalación del juego entre distintos backups hace que la mejora no sea tan absolutamente bestial a favor de los SSD en este caso; sin embargo, el SanDisk Extreme PRO se alza de nuevo con la victoria con una ventaja superior al 150%, mientras que el Intel 330 SSD se queda en torno al 135%. Aunque en este caso las distancias se acortan, el modelo de SanDisk sigue siendo alrededor de un 10% más rápido que su contrapartida de Intel.

Hemos agrupado, por un lado, todos los tiempos de inicio de los juegos, y por otro lado los dos benchmarks de carga de partidas, debido a las diferencias según el juego que podía haber entre la primera y la segunda carga. En este caso, vemos como las diferencias en los tiempos de inicio no son tan acusados entre las unidades: sólo hay un 75% de mejora entre el Extreme PRO y el Caviar Black. En el caso de las cargas de partida, la mejora queda en torno al 81% en el caso más favorable con el SD Extreme PRO, quedando el Intel 330 SSD muy cerca en números.

Estos últimos resultados pueden no parecer tan impresionantes, pero estamos hablando de una mejora típica cercana a la mitad de tiempos de carga. Además, como hemos podido comprobar en los análisis individuales de cada juego, en general se puede ver cómo cuanto más tiempo se tarde en cargar los niveles mayor es la mejora porcentual a favor a los SSDs.

El SanDisk Extreme PRO de 240 GB se alza victorioso contra nuestro Intel 330 SSD en todos los casos. Es comprensible: hablamos de un SSD moderno de gama alta contra uno algo más antiguo. Sin embargo, el modelo de SanDisk deja entrever un potencial mayor de lo habitual en situaciones concretas y no ha mostrado ninguna anomalía en ninguna prueba, cosa que confirma su condición de todoterreno de gama alta en el mercado de los SSDs.

Aunque la competencia al comprar SSDs tope de gama es dura a nivel de precios, SanDisk confía en que los 10 años de garantía supongan un factor diferencial que haga decantarse la balanza hacia su lado. A nosotros nos parece que, sin duda, es una de las mejores características que cualquier fabricante de componentes para PC puede añadir a sus productos. Tener la seguridad de estar cubiertos ante fallos de fábrica durante una década es algo que no se ve de forma muy habitual en el mercado de la tecnología. Unido a su magnífico rendimiento contra otros modelos de tope de gama, SanDisk tiene en sus manos uno de los SSDs más atractivos del mercado.

Concluimos con la certeza de que un buen SSD marca la diferencia en la experiencia de juego. En equipos de gama baja es mejor invertir el presupuesto en elementos que potencien el framerate o la calidad gráfica, pero a partir de cierta inversión nos parece imprescindible añadir un SSD como guinda del pastel y poder aprovechar mejor uno de nuestros mejores activos, como es el tiempo.

Análisis realizado con una unidad de prueba cedida por SanDisk.

Solo los usuarios registrados pueden comentar - Inicia sesión con tu perfil.

Pues me parece genial el artículo, ya me ha quitado las (pocas) dudas que tenía de meterle un SSD al portátil gaming, que todo lo que sea ahorrar tiempo en las pantallas de carga es EL BIEN.

Póngame dos, @mr_tonda

Como poseedor de un ssd de hace unos años ya la diferencia entre un ssd y un hdd normal es abismal. Y cada vez los mejoran más tanto en rendimiento como en fiabilidad y vida útil. Buena compra si tu equipo ya es suficientemente potente. Dicho esto es una buena inversión para pecés que no sean para jugar también. El arranque de aplicaciones pesadas, el arranque del SO y muchas otras cosas ven mejorías importantes.

Están geniales estos analísis y guías de @mrtonda

¿El otro día leí que habrá nueva guía de PC’s de sobremesa en breve?

@emedepan

Esta misma semana, aprovechando el lanzamiento de The Witcher 3. Tenía que haber estado para ayer u hoy, pero maquetar todas estas gráficas me ha llevado más trabajo del que esperaba xd

Me he mirado el análisis por encima y no sé si se comenta.

Al comprar uno cuidado con la capacidad y lo que le queráis meter. Si lo llenas al 50% su velocidad ya baja. Y al 75% es como tener un HDD. Al menos esto era así cuando compré el mío el año pasado, imagino que la cosa irá mejorando con el tiempo. También tened en cuenta que su vida útil es bastante inferior a un disco duro normal, cosa que también van mejorando con el tiempo.

Este tipo de discos también se pueden meter en consolas, ¿no?

Estoy pensando concretamente en la PS4 que se le puede cambiar el disco duro.

¿A que te refieres con vida util?… si lo garantizan por 10 años se entiende que es lo que te va a durar, y un disco duro con 10 años ya podemos considerarlo senior.

@tiobraulio

Aquí tienes un análisis publicado en Eurogamer.net, de Digital Foundry, con una comparativa del rendimiento en PS4 de un HDD normal, SSD y un híbrido (hay otro análisis para Xone también). Ergo, sí, se pueden enchufar en consolas. El análisis es algo antiguo pero para ilustrar, sirve.

Por otro lado, dada su naturaleza, más parecida a la RAM que a un HDD, se pueden «quemar» antes. Los SSD no son discos de verdad como los HDD tradicionales (o, bueno, una torre de discos, más bien; la palabra disco se usa aquí como un objeto que tiene forma de disco, no como el disco duro en sí, ojo). Tampoco necesitan desfragmentado, ya que el modo de lectura no es secuencial como los HDD de toda la vida. Generalmente, los fabricantes proporcionan drivers y aplicaciones que te informan de la salud del disco.

Aquí tienes más detallicos en forma de Wikipedia.

Lo de la vida útil era verdad hace años, pero ya no. En la última prueba de estrés que vi cualquier SSD aguanta miles de TB de escrituras sin dar ni un solo error:

http://techreport.com/review/27909/the-ssd-endurance-experiment-theyre-all-dead

De hecho eso los hace mucho más fiables y duraderos que un disco duro común.

Saludos, bonicos.

@napo2k

El problema de los SSD es que no conviene usarlos para tareas con mucha lectura/escritura de archivos pequeños.

Por ejemplo, yo los correos del gestor prefiero tenerlos fuera del SSD (siempre conviene tener un HD convencional para estas cosas), así como los archivos temporales del navegador, etc.

Y obviamente, mirar las conexiones de tu PC, que yo con conexiones SATA apenas noto diferencia

Yo pillé hace poco un Crucial MX100.

La cosa es que hice mi PC cuando los primeros i7 y tiene SATA2. Supongo que esto provoca un cuello de botella, pero, ¿hasta qué punto?

Yo noto que GTA V, Skyrim y Pillars of Eternity cargan algo más rápido (en Skyrim lo noto menos), mientras que con Farcry 3 no lo noto. También tengo DOTA 2 que aunque sí noto que carga más rápido, no sé si convendría más arrancarlo en un HDD. Me rayo un poco con el tema de la salud de los SSD, la verdad.

@guirao21

Sata II llega a 300 Mb/s. Te capa un poco la velocidad de escritura (330 Mb/s), pero sobre todo la de lectura (550 Mb/s). Aún así, la mejoría respecto los 30-70 Mb/s de un HDD medio es más que notable.

@elijah

@silvani

Ya veo que la cosa ha mejorado un puñao. Y eso es bueno.

Pero por tests y resultados que me he puesto a buscar (y esto depende del modelo), las velocidades de lectura y escritura se degradan «relativamente rápido».

Depende de cada cual, pero a mí, un SSD pequeñito (64-128GB, digamos) para Windows y alguna cosa más, y luego uno o dos mamotretos de 1TB o algo así, me sigue pareciendo la configuración ideal (incluyendo precios en la ecuación :D), y es con la que generalmente me encuentro más cómodo.

@tigrolvo

No lo comento porque me parece algo de nivel avanzado y porque, ojo, la degradación de rendimiento ocurre con las escrituras, no con las lecturas de datos. Y normalmente las ventajas de los SSDs a la hora de jugar (y para un uso normal, vamos) vienen en las lecturas, las escrituras son más raras. Esto quiere decir que un SSD lleno a, digamos, un 90% es mucho más lento escribiendo PERO no tanto leyendo; así que no se va a comportar como un HDD ni de coña, vamos.

Sobre la longevidad y la vida útil, ya te ha explicado un poco @elijah cómo funciona, y a día de hoy está más que probado que un SSD es más fiable y longevo que un HDD típico.

@silvani

No estoy muy de acuerdo con lo que dices. Los SSDs desarrollan todo su potencial con archivos pequeños, puesto que no tienen partes mecánicas que mover para acceder a los datos y el acceso a las celdas de memoria es intantáneo. Así como los HDDs morían principalmente por problemas mecánicos, y con lo cual cuanto más fragmentado estuviese el disco peor para su salud, la medida de vida de un SSD son las escrituras de cada celda. Así pues, es mucho mejor escribir 1.000 archivos que ocupen 1 MB entre todos que 1 archivo que ocupe 1.000 MB, te lo aseguro. Por eso, los formateos a bajo nivel (los lentos que borran todas las celdas completamente) son la muerte para cualquier tipo de unidad SSD y, en general, memoria flash (USBs, eMMCs, microSDs, etc).

@guirao21

El cuello de botella lo sufrirás más al mover archivos muy grandes y simples, lo que suele llamarse lectura y escritura potencial, que es dónde los SSDs desarrollan esos números tan bestias que anuncian de más de 500 MBs segundo. Sin embargo, un HDD típico suele andar por los 100 MB/s en valores secuenciales, la mejora en SATA 2 es de 3x como máximo y en SATA 3 de 5-6x.

El potencial real de los SDDs es en lecturas y escrituras aleatorias o con archivos muy pequeños. Ahí los SSDs, como he comentado antes, tienen una ventaja brutal sobre los HDDs al no tener partes mecánicas y típicamente están entre uno y dos órdenes de magnitud por encima de un HDD, es decir, un rendimiento de entre 10x y 100x. Eso en benchmarks y condiciones ideales, claro, pero la realidad es que su magnífica velocidad la sacan de ahí y de los tiempos de acceso tan bajo que tienen.

Por otro lado, ten en cuenta que en algunos juegos se puede tirar mucho de procesador cuando se inicia y que sea éste, y no el SSD/HDD, el cuello de botella al arrancarlo.

Hombre, eso por supuesto, ahora mismo lo que mejor sale para tener velocidad y un precio por GB decente es un SSD de 256 o 512 y luego un magnético de 3 o 4 TB, y ya a partir de ahí la política de copias de seguridad que tenga cada uno.

Hay muchos mitos, el SATA II, de 3 Gbps funciona casi igual en aplicaciones reales, aún con SSD, los 500-600 MB/s que puede dar el SATA III (6 Gbps) sólo los da en lectura secuencial, que está muy bien en laboratorio pero se usa poco.

Comprando hoy un SSD con TRIM (que en 2015 todos tienen) y procurando que no se llene más del 80-90% (que ahí también te jode el NTFS) sobra. Lo del 50% era antes, cuando no había TRIM y no llevaban los SSD espacio de reemplazo para cuando alguna celda se rompe (y para aumentar la velocidad).

En resumen, que son más rápidos y más fiables, los magnéticos lo que tienen mejor es el precio por GB

@mr_tonda

Justo lo que dices, y también es bueno añadir que se calientan menos, no hacen ruido y son resistentes a golpes y movimientos porque no tienen cabezal móvil. Para un portátil son ideales.

Anait marcando la diferencia una vez más.

MLC ó TLC, es lo primero que me pregunto. Me parece que no se especifica en el artículo, y yo personalmente, si puedo prefiero comprarlos con memoria MLC, como el caso del Crucial MX100.

Después, conste que no conozco la distribución que se hace de los chips de memoria en los dos SSD que se comparan, el Sandisk y el Intel, pero me parece algo injusto poner cara a cara un disco de 180GB con uno de 256. En los SSD, suele cumplirse la máxima de que a mayor capacidad, mejor rendimiento, por la mayor posibilidad de trabajar en paralelo con varios chips a la vez.

Pero los 10 años de garantía que da Sandisk, si luego responde bien, son algo a tener muy en cuenta.

Enhorabuena por conseguir que los fabricantes os cedan componentes. Es el primer paso para iniciarse en el análisis de hardware y que no está al alcance de todo el mundo, a muchos nos toca comprar y probar. A ver si se ven más como este de gráficas o placas base, que es en lo que, al menos yo, suelo dudar más.

Saludos.

Yo no me canso de decirlo, de verdad, que nadie dude que ponerse un SSD es el cambio que más va a notar en el rendimiento general del pc (no en los juegos, aunque solo por eliminar los tiempos de carga ya vale la pena).

Adiós a la pereza de reiniciar cuando se instala una actualización, al instalar software pesado, al abrir el puto photoshop… joder, que mi HTPC con SSD se enciende más rápido que la tele a la que está conectado!!

@sephirots_blade

Sobre las memorias… Cada día sale algo nuevo que la tecnología. Entre esas dos yo también me quedaría con MLC en general, pero en realidad depende de muchas más cosas además del tipo de memoria si hablamos de longevidad.

Sé que es un poco injusta la comparación, pero no tanto como parece. Las grandes diferencias suelen estar entre los primeros escalones de memoria, es decir, entre 64 GB y 128 GB, y entre 128 GB y 256 GB. Entre 180 y 240/256 GB no hay tanta diferencia como parece, de normal.

En cualquier caso, son gamas distintas, por eso quería compararlos. Y siendo sinceros, el único SSD que recibí fue el SanDisk, el Intel 330 y el Caviar Black son de mi equipo, así que era lo único que tenía a mano para comparar. De todas maneras, creo que sirve para ilustrar la diferencia entre distintos tipos de unidades, que era el objetivo del artículo.

Y gracias por los ánimos Sephi, de verdad! Estamos empezando y la verdad es que los inicios siempre son complicados, pero creo que en Anait, como página de videojuegos que es, tenemos que publicar análisis menos técnicos y más enfocados a lo que queréis los jugadores, y por eso seguramente eches en falta otro tipo de benchmarks en la review. Quería hacer un análisis distinto y útil, porque al menos para mí, como gamer, me dicen muy poco los análisis típicos de SSDs que se ven habitualmente. Desde un punto de vista técnico sí que me interesan, pero para jugar son bastante inútiles. Sino, mira este tipo de gráficas de TechPowerUp:

http://tpucdn.com/reviews/Kingston/HyperX_Savage_240_GB/images/battlefield4.gif

Las ves… Y te quedas igual que si no las hubieses visto.

@mr_tonda Claro, la verdad es que has acertado orientando el artículo de otra forma. Al fin y al cabo esto es una página de videojuegos y lo que interesa son eso, PCs gamers. A veces lo pierdo un poco de vista, para qué negarlo, pero tienes razón.

Yo es que gamer, lo que es gamer… digamos que hace tiempo que hablo más de videojuegos que juego a ellos, pero bueno, ya llegarán tiempos mejores -quizás el año que viene, quizás el otro- con el salto al PC y la VR.

Joder, pues vaya si se nota 🙂

Recuerdo una comparación en Neogaf sobre discos duros de PS3 o PS4 y se notaba también.

@mr_tonda

Vaya, pues cuando me estuve informando de su mantenimiento, en todas partes, pero en todas, el 100%, mencionaban que nada de usarlo para tareas de escritura/lectura repetitivas. Y luego que si el TRIM, que si quitar el indexado de Windows, que nada de desfragmentar…

Ah, y que cuando el disco perdiera rendimiento, la única forma de recuperarlo era con un formateo a bajo nivel WAHT .

Quizás no me fijé en la fecha y se trataba de procedimientos para discos antiguos.

@silvani

Y leíste bien, imagino. Pero escribir archivos pequeños no es igual a lecturas y escrituras repetitivas. Supongo que lo que leíste se refería a cosas como servidores o grabado de datos contínuo típico de copias de seguridad, en las que la unidad se puede pasar 24h al día escribiendo datos. En esos casos, un HDD es mejor porque la degradación la sufren las piezas mecánicas, y si éstas son de buena calidad la vida puede ser virtualmente infinita. En el SSD, la degradación la sufren las celdas de memoria, y ahí sí que está bastante más medido cuantoas escrituras puede sostener una celda estándar.

Para clarificar: en caso de escrituras contínuas, sí, un HDD mejor. Pero mientras no pretendas llenar y vaciar el SSD por completo una vez al día, mejor un SSD.

El TRIM y la llamada ‘Garbage Collection’ son a efectos prácticos lo equivalente a la desfragmentación en SSDS. El indexado se suele quitar más bien porque no sirve de nada en SSDs, es una herramienta para mejorar el tiempo de acceso en HDDs pero en SSDs es tan bajo que es innecesario. Se quita porque bueno, no lo necesitas y libras al SSDs de unas cuantas escrituras diarias, aunque nada grave.

Para recuperar el rendimiento están el TRIM y el Garbage Collection, ni se te ocurra formatearlos a bajo nivel, de verdad.

Excelente artículo. Me has convencido, para después de verano seguramente caiga uno.

@mr_tonda

Bueno, más que nada lo comentaba porque yo uso el pc tanto para juego como para trabajo. Mucho photoshop, estar guardando constantemente, sobreescribiendo archivos grandes y tal.

Al final el SSD lo uso solo para SO y curro. Quiero que me dure y siga rapidete.

Recomiendo los Samsung Evo, funcionan de puta madre.

La experiencia que tengo en SSD tanto en portátiles como equipos de sobremesa es espectacular. Tengo un HP 530 mononucleo con un intel celeron y le cloné el hdd a un hdd ssd de 64 gb precisamente de la marca Sandisk. El equipo parece nuevo, los tiempos de lectura y escritura son increíbles, también parece que la batería dura algo más al no consumir tanto por el mecanismo del hdd mecánico.

Al ver el cielo abierto con este bicho, decidí comprar uno de 128 gb también de Sandisk al equipo de sobremesa. Particionado con win7 y linux mint 17, los tiempos de carga son rapidísmos, en apenas 6 segundos tengo cargado windows 7, pero esque en linux mint son 5 segundos de carga. Vamos que estoy la mar de contento con estos discos, en un futuro compraré uno de mayor capacidad para tenerlo como disco esclavo.

Un saludo

Genial artículo, tengo intención de añadir un ssd a mi pc y esta guía me va a venir genial.

Muchas gracias!

Sólo 2 SSD en la comparativa? Echo en falta alguno más

Montados en equipos antiguos les hacen vivir una segunda juventud. A día de hoy son un must, que nadie dude en ponerle uno a su equipo si aún no lo ha hecho.

Usualmente suelo elegir para ellos Kingston, Samsung o Crucial, en mi caso opté por el Kingston de alta gama, y es demencial la rápidez con la que trabaja con el sistema operativo y la caché.

Pero claro, mi equipo no es como los que suelo reparar-montar, más dirigidos a usuarios normales con uso internet-trabajo-multimedia. Ya me va tocado meterle caña con juegos. Desde ahora tendré muy en cuenta la calidad de SanDisk, y el Extreme Pro será mi próximo SSD, si no ha salido otro de aquí a que falle, que solo tiene un par de años. Esos 10 años de garantía son oro puro.

Increíble review, @mr_tonda. Gracias y enhorabuena :bravo:

¿Para que fuera un análisis completo no deberíamos tener en cuenta el precio también? lo digo porque no me ha parecido verlo por ningún sitio y me parece importante.

@redgar

En el equipo de pruebas tienes enlaces a los productos para ver su precio actual en Amazon. No lo he puesto como algo oficial en el artículo porque bueno, los precios fluctúan y en este tipo de artículo no lo consideraba necesario, pero si os gustaría leerlo también aquí lo tendre en cuenta para futuros artículos.

Genial articulo. Tengo pensado pillarme un SSD y toda informacion de este tipo es bienvenida.

@tigrolvo

La mala fama en cuanto a durabilidad de los SSD es en gran medida debido sobre todo un par de malentendidos. Por un lado que los SSD tienen una cantidad de escrituras limitada pero sobre todo relativamente definida, frente a un disco duro, pero estos también se desgastan (mecánicamente). La diferencia es que un SSD en principio solo se desgasta con escrituras, las lecturas no le afectan en cuanto a durabilidad (al menos no en cuanto al agotamiento de los ciclos de escritura, pero sí puede fallar por estropearse la electrónica, igual que un HD), mientras que un disco duro se desgasta más o menos de forma similar con ambas escritura/lectura.

Otro malentendido es relativo al tiempo entre fallos, y es que la durabilidad de un disco duro (o un SSD) es algo distinto. Si un disco duro tiene por ejemplo, 1.000.000 de horas de tiempo entre fallos, no significa que vaya a durar esas horas, sino que si cambias el disco duro cada vez que se agota la duración prevista de la unidad (la duración de la garantía), es de esperar ese número de horas de media antes de que se produzca un fallo. Por eso el tiempo entre fallos es una medida de fiabilidad, no de durabilidad.

Aparte, los SSD tienen controladoras internas que agrupan escrituras y las reparten por toda la unidad, lo que se llama Garbage Collection, de modo que no se escriba continuamente sobre las mismas celdas y se agota la durabilidad de una pequeña zona de la capacidad. Por otro lado su capacidad real suele ser superior a la disponible, de modo que aun con casi nada de espacio disponible todavía cuenta con cierta capacidad no visible en la que repartir escrituras, sin concentrarlas en el poco espacio que nos quede.

Como muestra bastante clara está el que cada vez más se condicionan los años de garantía de los discos duros a las horas de funcionamiento que haya tenido. Si quieres más garantía para un uso intensivo de un disco mecánico toca pagar más por un disco duro de gama superior que en realidad es mismo disco duro físicamente pero con distinto nombre, ligeramente distinto firmware, más tiempo de garantía y mayor precio.

En cuanto al rendimiento, aparte de ser mayor en los SSD también es mucho más estable y uniforme. Dependiendo de la controladora concreta que lleve el rendimiento puede ser o no ser similar con el SSD vacío que estando incluso un 99% lleno tanto en lectura como en escritura, pero en un disco duro nunca es así, ya que todos por la forma de funcionar, son siempre más rápidos en el comienzo del disco (la zona exterior de los platos internos) duro y más lentos en los últimos GB (la zona interior).

@Silvani

Como indica Mr. T, la potencia real de un SSD, tanto en lectura como escritura es precísamente con archivos pequeños, cuanto más mejor. Por ejemplo, guardando un archivo de 8GB un SSD de 500 MB/S puede ser tres veces más rápido que un disco duro que vaya a 150 MB/s, pero si se trata de un caso extremo con muchos archivos muy pequeños el SSD puede bajar quizás a 300 MB/s mientras que el disco duro baje a menos de 1 MB/s.

No hay más que recordar que los antiguamente ´fórmula uno´ de los discos duros para gamer, los Raptor, eran considerados mejores que los discos duros normales no tanto por su velocidad secuencial sino por sus considerablemente mejores tiempos de acceso (la mitad o un tercio de lo normal), pero un SSD puede tener tiempos de acceso un par de órdenes de magnitud mejores que el mejor disco duro. Un raid de discos duros puede ser más rápido que un SSD moderno a la hora de copiar una iso de varios GB (secuencial), pero en tareas que se beneficien de buenos tiempos de acceso incluso un SSD antiguo (salvo que sea de los muy antiguos, y dentro de estos que sea de los de más baja calidad) barre a cualquier raid de discos mecánicos.

Respecto al indexado, este ciertamente no es muy útil para indexar archivos del SSD, donde su tiempo de acceso lo hace innecesario, pero sí que es beneficioso indexar el contenido de los discos duros en un archivo situado en el SSD, que lógicamente podrá moverse de él con mucha más rapidez, y sobre todo, sin verse afectado por otras operaciones de lectura/escritura que estemos realizando en el SSD (otra vez, debido a los tiempos de acceso).

@danko9696

Muchas gracias por la explicación =)

@mr_tonda Gracias por la advertencia de NO formatear a bajo nivel, son pequeños datos que muy pocas personas dan, simplemente porque se da por hecho que todo el mundo lo sabe y no es así. Ahora, para que sirve el formateo a bajo nivel si lo que puede es dañar tus memorias? Solo sirve para los HDD?

@basilisk

Bueno, no es que las dañe, sino que las desgasta innecesariamente. Un formateo a bajo nivel sirve para eliminar por completo la información de una unidad. Básicamente, si la información básica en informática se escribe en ceros y unos, un formateo a bajo nivel llena de ceros la memoria de la unidad.

La diferencia es que un formateo normal (o cuando borramos un archivo de la unidad) es que en el formateo normal lo que realmente ocurre es que la información se marca como ‘borrable’, con lo que el sistema operativo puede escribir ahí cuando quiera. Pero realmente la información sigue ahí hasta que esa parte de la memoria se sobreescriba con algo nuevo.

Los formateos a bajo nivel sirven para varias cosas. La función más típica es para borrar realmente la información y que no sea recuperable; esto es normal en casos de tener información confidencial en la unidad y asegurarse de que no se podrá recuperar al venderla, reciclarla, o en general deshacerse de ella. También se usa bastante cuando hay sectores dañados en un HDD, pero las herramientas habituales no los detectan o simplemente detectan que están en riesgo, pero no tienen la certeza de que estén dañados o no hasta probar a escribir. Con un formateo en bajo nivel escribes información en ese sector y ya se puede saber si está dañado o no. Además, si la unidad tiene sectores de sobreaprovisionamiento los puede usar para reemplazar los sectores defectuosos por los de reserva.

Hay más usos para los formateos a bajo nivel, como tratar con virus particularmente persistentes en el arranque y demás, pero los más típicos son los comentados arriba.

Por cierto, excelente explicación de @danko9696, yo no la habría hecho mejor. Me mola mucho ver a gente que controle tanto del tema por aquí, como también @elijah que ha comentado más arriba.

@mr_tonda

El artículo ya está muy bien, valoro mucho que uses tests reales en lugar de sintéticos, es lo que siempre les digo a mis alumnos: los tests lo más cercanos al mundo real.

Kudos sobre todo por resolver las dudas en los comentarios, se nota que hay nivel por aquí, sí.

@mr_tonda

@tigrolvo

Gracias por las explicaciones, ahora queda todo más claro.

:bravo:

Mr. T

Otro pequeño wall of text XDD

El formateo a bajo nivel no borra realmente la información ni es útil para evitar la recuperación de información altamente confidencial. La razón es que los datos, en última instancia se guardan de forma analógica, de modo que con herramientas hard y soft especializadas es posible recuperar información incluso sobreescrita diréctamente varias veces o procedente de equipos parcialmente dañados (de un incendio en una empresa por ejemplo).

De hecho técnicas basadas en el mismo principio pueden permitir cosas como recuperar información de la ram (contraseñas típicamente, dado que justo en el momento de usarse en ram estas no están encriptadas) de un equipo apagado reciéntemente, extrayendo los módulos de memoria y refrigerandolos inmediatamente para ganar más tiempo aumentando las probabilidades de éxito, o recuperar fotografías de una tarjeta de memoria SD a pesar de haberse sobreescrito por completo con otros datos.

Tampoco es que no sirva de nada, ya que es muy caro recuperar datos a este nivel pero si se trata de información muy valiosa o se trata de un procedimiento forense, un único formateo a bajo nivel (una única pasada de ceros) sin más no ofrece apenas garantías.

La única forma realmente fiable para evitar recuperación de datos es la sobreescritura del disco entero con datos múltiples veces, realizando pasadas de ceros y de números aleatorios repetidas veces junto con un borrado posterior mediante potentes imanes y la propia destrucción física del disco duro, existiendo herramientas para cada tarea, tanto para la parte soft como la destrucción del hard y también de todo en uno. Esto puede parecer exagerado pero es el pan nuestro de cada día en grandes empresas y organizaciones gubernamentales con información sensible, que obviamente no venden sus discos duros de segunda mano cuando termina su vida útil.

Respecto a los sectores dañados, no hace falta escribir a bajo nivel para detectarlos, ya que si un sector lo está no da problemas solo al escribir en él sino también al intentar leerlo, claro que para ello es necesario intentar leer todos y cada uno de los sectores del disco duro (lo que puede llevar mucho tiempo si el disco es de gran capacidad), y por eso en las herramientas de chequeo esto es opcional, frente a una mucho más rápida comprobación del sistema de archivos sin más.

Hace poco me cascó un disco duro de 2TB. No totalmente muerto pero casi. Windows tardaba como media hora en arrancar (frente a los 20 segundos habituales) si el disco dañado se encontraba conectado. Después de 11 horas conseguí chequear la superficie del disco duro entera (deteniendose varios minutos en cada sector dañado) y recuperar la gran mayoría de datos, pero tener en cuenta que tenía pocos archivos para su capacidad. Si hubiese estado lleno de archivos pequeños el proceso podría haber durado varios días y la exploración de superficie habría supuesto solo una pequeña parte del tiempo empleado (en otro disco duro sano de la misma capacidad el chequeo de superficie duró 9 horas, con 0 problemas).

El disco duro era usado como almacén secundario para multimedia de datos poco frecuentemente accedidos y ha petado después de tres años. En cambio mis dos SSDs intel de hace 6 años, usados como discos de sistema uno y aplicaciones otro, funcionan como el primer día (al menos de momento). Nunca me ha durado tanto una unidad de sistema y no han perdido prestaciones, y eso que durante un par de años los usé en RAID sin TRIM (por usar RAID) ni Garbage Recolection moderno (algo sí tienen al respecto pero dependen más del TRIM que no usaba).

Por mi experiencia personal y lo que investigué en su momento, aunque llevo un buen tiempo desconectado del tema, si un SSD no es defectuoso de salida (por hard o firmware), o sea, si no peta a los pocos meses (hubo algún caso sonado en las primeras generaciones de SSD), es bastante más durable que un disco duro normal.

A mí me costaron una pasta en su momento porque soy un nerd pero hoy en día no hay excusa para cualquiera que desee comprar un equipo de prestaciones medias-bajas en adelante. Hoy en día no tiene sentido un pc sin SSD salvo que hablemos de gama baja en todos los componentes. No es tanto que los programas tarden objetivamente mucho menos en cargar (sobre todo si son pequeños) sino que la sensación subjetiva de velocidad es mucho mayor, dado que el PC responde más rápido en todo tipo de tareas de uso cotidiano y se nota bastante más que una CPU de gama más alta. La ganancia de velocidad puede ser de tan solo un par de décimas de segundo en un pequeño programa, por ejemplo, pero la sensación de fluidez es mucho mayor, dado que el tiempo de respuesta desde que hacemos click con el ratón hasta que vemos que pasa algo se reduce considerablemente, aunque el tiempo de carga en sí no se haya reducido tanto realmente, sí la latencia, aunque no sea tan sencilla de comprobar como tiempos de carga en aplicaciones pesadas o juegos.

Aparte de cargar más rápido el SO, la experiencia de poder comenzar a usar el ordenador de verdad, abriendo carpetas y aplicaciones nada más ver el escritorio es algo que no tiene vuelta atrás, frente a tener que esperar a que el disco duro termine de rascar, sobre todo si el equipo está bien cargado con programas residentes e instalaciones.

@danko9696

Algo me olía con la recuperación de datos a pesar del formateo a bajo nivel, pero desde luego ahora me queda mucho más claro lo que ocurre realmente. Al fin y al cabo sigo siendo un usuario más y al final quedo vendido a lo que leo en webs de hardware sobre el tema. Aunque siempre intento que las fuentes sean fiables, vamos.

Lo de los sectores dañados es tal y como dices, la verdad es que no me he explicado muy bien, pero la idea que queria transmitir era precisamente la de que hasta que no se pega una pasada a todo el disco no tienes la certeza de haber detectado todos los sectores. Tengo un HDD por ahi con un sector pendiente desde hace siglos, y cuando lo lleno de datos me desaparece y la info SMART dice que todo está correcto, para que al cabo de un tiempo al liberar algo de espacio me vuelva a aparecer como pendiente. Siempre he sospechado que el sector pendiente algo tenía que ver con que Windows me tardase en arrancar con ese HDD conectado, pero ahora que me lo confirmas… Una cosa más que aprendo.

A día de hoy estoy pensando muy seriamente el comprarme un Seagate de 8 TB, que tienen un precio muy bueno por TB y parece que rinden muy bien, pero cada día me dan más respeto los HDDs tan grandes y casi prefiero usar unidades externas para almacenar datos, que puedes desconectar y conectar cómodamente y evitar parte de su desgaste. Pero claro… Un HDD de 3.5 externo es un armario que requiere alimentación adicional, y se pierde parte de la comodidad de tenerlo dentro de la caja. Dudas, dudas…

@Mr. T

Ya, el problema está en que el chequeo por defecto no comprueba toda la superficie del disco sino que hay que activar la opción (sea bajo la UI de windows o en linea de comandos), cosa lógica dado lo que tarda, y también la propia duración y falta de feedback. Una pasada en profundidad a un disco duro de gran capacidad tarda mucho y si no sabes como va la cosa es muy fácil pensar que se ha colgado, ya que puede pasar bastante rato sin ver ningún avance en el proceso de chequeo.

Si lo haces desde windows con chkdsk también ocurre que ves que casi toda la ram que tengas (aunque sea mucha) es consumida, lo que también puede mosquear, cuando unas advertencias de la propia aplicación podrían tranquilizar a un potencial usuario nervioso ante la incertidumbre de no saber si va a poder recuperar algo de los datos y encima ahora no saber que está pasando.

De las utilidades Smart la verdad es que no me han servido de gran cosa. Después de este problema pasé chequeo a los demás discos duros y comprobé los datos Smart y los valores eran muy similares entre disco dañado con sistema de archivos ya reparado y discos sanos, o sea, aunque hubiese estado pendiente de ello no me habría ahorrado el problema.

Respecto al tema del disco duro externo opino lo mismo. Es una lata tener que andar con otro cable de alimentación y otro trasto. Si tienes sitio en la caja para mi la mejor opción es una carcasa para bahía de 5 1/4 que permita introducir y extraer el disco duro de la caja como si fuese un diskete. Dependiendo de la placa y drivers/aplicaciones específicas para el chipset sata que usemos (la placa puede tener más de uno) se puede hacer en caliente, pero yo siempre introduzco o quito el disco duro en frío, resultando en un disco duro interno a todos los efectos que puedo quitar y poner (u otro distinto) en cuestión de 5 segundos con el equipo apagado.

@danko9696

Pues mira, me animas aún más a hacer lo de la bahía de 5,25″. Era algo que consideré hace tiempo pero que nunca me había animado porque no me convencían los modelos económicos que veía, y los que sí que me convencían se iban a 50+ €. Pero viendo que el precio de 8 TB es bastante asequible lo mismo me animo y me busco una carcasa.

Puestos a profundizar con el tema, quería preguntarte algo bastante específico: como sabrás, hace unos cuantos años algunos modelos de Caviar Green tenían un problema de aparcado de cabezales excesivo que, supuestamente, se los acababa cargando mucho antes de lo esperado. Se solucionaba actualizando el firmware, y que yo sepa a día de hoy ya no ocurre -como era de esperar-. En aquel momento yo tenía un portátil con un HDD Seagate de 500 GB, y me fijé en las estadísticas SMART (la única herramienta que conocía) que aunque el aparcado de cabezales no era tan bestia como en los Caviar Green, sí que estaba bastante por encima de los valores recomendados.

En ese momento decidí que tenía que buscarme un SSD sí o sí, pero mientras lo hacía busqué alguna manera de bajar la tasa de aparcamiento de cabezales, y al final dí con una utilidad llamada quietHDD que básicamente permitía controlar los ajustes de ahorro de energía de los HDDs y así evitar que aparcase excesivamente los cabezales. Después de ajustar los parámetros, efectivamente el ritmo de aparcamientos bajo considerablemente. Muchísimo, vamos. Pero el disco ya había sufrido demasiados aparcamientos y cuando lo pasé a una carcasa externa no duró mucho más de 3 o 4 meses antes de morir.

La duda que me quedó fue saber realmente por qué había muerto. Entiendo que es imposible saberlo a ciencia cierta sin tener el disco delante y herramientas para ello pero, ¿crees que el aparcamiento excesivo de cabezales pudo ser la causa? ¿O era más probable que al darle mucho trote como HDD externo, en una carcasa barata, se fuese al traste? He de decir que tengo otro HDD externo en la misma carcasa desde hace un montón de tiempo y sigue sin problemas, aunque le doy un uso testimonial a día de hoy. El número de aparcamientos no había sobrepasado la media a partir de la cual pueden empezar a fallar los discos, pero sí que se había quedado peligrosamente cerca en términos estadísticos (digamos, un 70-75%) en sólo un par de años, así que siempre pensé que quizá Murphy hizo valer su ley sobre la campana de Gauss.

Y sobretodo, ¿te parece adecuado usar este tipo de herramientas? No conozco otra que haga lo mismo que quietHDD en Windows y tengo guardado el programa como paño en oro, a falta de saber si es adecuado usarlo o no. Con el Caviar Black que tengo actualmente no lo necesito porque bueno, el aparcamiento de cabezales es casi inexistente, pero nunca está de más saberlo para el futuro.

@Mr. T

La bahía extraíble de 5 ¼, salvo que tenga un diseño y acabados especialmente buenos o alguna otra característica extra debería ser barata, ya que se trata (al menos la que yo me refiero) esencialmente de un adaptador directo de cable SATA en forma de carcasa rígida, o sea, no hay electrónica. Alguien que sea manitas y le gusten los DIY seguro que se podría montar uno aprovechando un reproductor de CDs estropeado o algo parecido.

De los aparcamientos, pues sí puede ser eso, ya que diferencias en el firmware con ligeras optimizaciones es básicamente lo que cobran en muchas ocasiones cuando compras un disco duro un escalón por encima, ya que con la competencia de precios no tienen apenas margen en las gamas más bajas, pero como dices es muy difícil de saber realmente. Puedes haber comprado dos discos duros identicos, usar uno mucho más que el otro y estropearse el menos usado.

Una utilidad como el quietHDD lo lógico sería usarla solo con unidades internas. Con externas o en portátiles tiene bastante más razón de ser que lo cabezales sean aparcados frecuentemente, en cuanto lleve un poco de tiempo sin utilizarse el disco. Pero claro, lo suyo sería que se pudiese configurar fácilmente desde alguna opción nativa de windows en adición a las ya existentes. No sé hasta que punto la utilidad de quietHDD puede ayudar realmente, pero siendo residente y sin hacer modificaciones permanentes en el firm de disco duro puede ser interesante, de hecho creo que la echaré un tiento.

@mr_tonda

@danko9696

Yo hace tiempo que los discos duros magnéticos sólo los pongo internos en RAID. Para reducir desgaste y poder almacenarlos más cómodo uso un dock USB3, lo veo mucho más cómodo que usar uno de bahía de 5 1/4: enchufas los discos duros cual cartucho de Super Nintendo, enciendes y luego extraes con seguridad y apagas. Yo lo veo ideal para copias de seguridad y datos de poco acceso.

Respecto al SMART, yo lo uso principalmente por el log de errores y la posibilidad de que los discos duros pasen tests largos. Los valores SMART cambian demasiado entre generaciones de discos duros y ni siquiera hay un estándar oficial que diga cómo interpretarlos exactamente. Hace un tiempo una empresa sacó datos estadísticos sobre probabilidades de fallo, pero sigue siendo poca cosa:

http://www.computerworld.com/article/2846009/the-5-smart-stats-that-actually-predict-hard-drive-failure.html

Mi experiencia es que si un disco duro pasa un test SMART largo y no ha tenido errores nunca, es de fiar, y en el taller trabajamos con discos duros todavía de 40 GB, y bastante maltratados.

A partir de ahí con dar por hecho que más tarde o más temprano todos los sistemas de almacenamiento fallan ya lo tengo claro: a tener copia de lo importante y cuando vaya petando cada disco a reconstruir el RAID o a volver a hacer copia de seguridad en un disco duro nuevo.

Los discos duros que ya son poco de fiar los suelo usar de disco duro externo para llevar datos de un sitio a otro, basta con un adaptador SATA a USB de estos pequeños con alimentación externa, el que yo tengo también lleva IDE para los viejos del todo.

Buffff, qué anciano me siento 😁

@elijah

Yo suelo ignorar el Smart, como dices la única prueba fiable es pasar un chequeo intensivo, y si no hay sectores defectuosos reparados, es que de momento va bien, no hay otra. Puedes tener dos discos similares comprados a la vez y con valores casi idénticos de Smart, y petar uno y el otro durar tres años más o seguir vivo todavía, como me ha ocurrido en el pasado tanto usando RAID0 como RAID5. Por eso ya paso de comerme mucho el coco como antes.

También hago lo mismo en ocasiones con los discos poco de fiar, que aunque tengan el sistema de archivos reparado sabes que tienen sectores defectuosos pero prefiero tirar de pendrive o de disco duro externo de 3 ½ alimentado por usb.

Del dock USB pues depende. Si lo tienes siempre a mano seguro que es más cómodo, yo también tengo uno USB3 dual pero prefiero no utilizarlo, solo si no me queda más remedio, porque es una lata sacarlo de la caja, poner los cables, etc… Ya tengo lío de cables de sobra como para añadir otro más. El día que vaya a hacer backup meto el disco duro antes de encender el ordenador y lo quito después de apagarlo al final del día. Solo uso el dock si voy a manejar varios discos duros externos pero es raro.

Y por cierto, que también tengo una carcasa para discos IDE por ahí, con algún disco vivo, aunque ya no los toco por tener los datos en discos más modernos XD

@danko9696

En la mayoría de placas modernas también puedes poner el SATA donde tengas la bahía extraible en modo Hot plug. Yo lo hacía una temporada con una caja que me sacaba un SATA como eSATA y el Windows lo ponía como una unidad extraible más, pero claro, para un interno me fío poco de quitarle la alimentación sacándolo. Yo uso muchos discos duros sueltos y claro, lo de tener el dock en la caja ni se me pasa por la cabeza, está siempre enchufado, con sus dos ranuras, también es ideal para clonar discos duros.

No hay forma óptima, cada cual nos organizamos según nos haga falta ☺

@elijah

Si, de hecho no necesito tener el ordenador apagado para extraer o introducir el disco duro, puedo quitar e introducir el disco duro en caliente, pero tampoco me fío demasiado de que no vaya a dar problemas a la larga (por desgaste del conector, por ejemplo), así que prefiero no acostumbrarme a ello, ya que tal como lo tengo funciona sí o sí, use windows u otro SO, aunque sea legacy, un live cd o lo que sea, y si se rompiese internamente el adaptador no debería suponer un fallo catastrófico, por conectarlo siempre en frío.

Y está claro que todo depende del uso que le demos. Sí que he pasado por temporadas de usar varios tipos de raid y carcasas y dock usb a saco, pero hoy en día prefiero mantenerlo un poco más simple dentro de lo que cabe dado que mis costumbres han cambiado, teniendo en cuenta que ya no es solo el pc lo que hay que tener en cuenta sino espacio para tablet/smartphone, docks para estos, etc…

@mr_tonda

Buenas. Estaba mirando en pccomponentes el precio de este modelo de SSD y he visto que no había ninguna review, asi que he introducido esta. No hay problema, no?

@mordroc

Sin problemas tío. Precisamente hoy iba a hablar de SSDs porque me he hecho con uno para el nuevo PC y dejaré el Intel 330 para el PC antiguo.